Aprenentatge supervisat

Dins l'aprenentatge automàtic i la mineria de dades, l'aprenentatge supervisat[1] és una tècnica per deduir una funció a partir de dades d'entrenament. Les dades d'entrenament consisteixen en parells d'objectes, sovint vectors, on una component són les dades d'entrada i l'altre correspon als resultats desitjats. La sortida de la funció pot ésser un valor numèric, en el cas de problemes de regressió, o bé una etiqueta de classe, com en els problemes de classificació. L'objectiu de l'aprenentatge supervisat és crear una funció capaç de preveure el valor corresponent a qualsevol objecte d'entrada vàlid després d'haver vist una sèrie d'exemples, les dades d'entrenament. Per això, s'ha de generalitzar a partir de les dades presentades a situacions no vistes anteriorment.

Informació general

[modifica]L'algorisme genera una funció que relaciona cada entrada amb la sortida desitjada. En el cas de problemes de classificació tenim que el sistema ha d'aprendre una funció (aproximar la conducta de la funció) a partir d'uns exemples que s'expressen en termes de l'aplicació d'un vector a un conjunt de classes. És a dir, es proporciona un conjunt de dades al sistema que han estat etiquetats de forma manual amb els valors esperats. Les xarxes neuronals (supervisades) i els arbres de decisió són exemples d'algorismes d'aprenentatge supervisat. La base de coneixement del sistema està format per exemples d'etiquetatges anteriors.

Procés d'implementació

[modifica]Per tal de resoldre un problema d'aprenentatge supervisat, com ara reconeixedors d'imatges, de veu o de qualsevol altre tipus, s'han de considerar diversos passos:

- Per començar s'ha de decidir el tipus de dades que s'utilitzaran com a exemples per a l'entrenament: mida de les imatges, durada de les pistes d'àudio, per exemple.

- Seguidament s'ha de crear el conjunt de dades d'entrenament, que s'han d'ajustar a les característiques d'aquelles dades que posteriorement voldrem reconèixer. Per tant constarà d'un conjunt d'objectes d'entrada i les seves corresponents sortides, anotades manualment a partir de diferents mesures i experiments.

- Haurem de determinar la funció d'ingrés de la representació de les dades, és a dir, l'estructura de les dades d'entrada. Normalment, l'objecte d'entrada es transforma en un vector de característiques descriptives que permetran preveure amb certa precisió la sortida.

- Determinar l'estructura de l'algoritme adequat per resoldre el problema i la tècnica d'aprenentatge corresponent. S'ha de treballar en un disseny que estudiï certes característiques dels objectes d'entrada per tal d'extreure paràmetres que permetin donar una sortida adequada a les nostres necessitats.

- Completar el disseny. L'enginyer ha d'executar l'algoritme d'aprenentatge ajustant-lo mitjançant l'optimització de rendiment amb la validació creuada. Després d'ajustar-ne els paràmetres i l'aprenentatge, es pot mesurar el rendiment de l'algoritme utilitzant diferents conjunts de proves independents de les d'entrenament.

Un terme de l'aprenentatge supervisat són els classificadors. Existeix una àmplia gamma de classificadors, cadascun amb els seus avantatges i inconvenients. Els més utilitzats són les xarxes neuronals, l'algoritme dels k veïns més propers, el classificador de Bayes i els arbres de decisió.

Altres factors a considerar

[modifica]A l'hora d'escollir les dades d'entrenament i l'algoritme d'aprenentatge s'han de considerar, a part dels passos anteriors, alguns factors com ara:

- L'heterogeneïtat de les dades. Si els vectors de característiques inclouen característiques de diferents tipus (discreta, discreta ordenada, compte, valors continus), alguns algorismes són més fàcils d'aplicar que d'altres. Molts algorismes, incloent màquines de vectors suport, regressió lineal, regressió logística, xarxes neuronals i mètode del veí més proper, requereixen unes característiques d'entrada en forma numèrica i escala de rangs similars (per exemple, en l'interval [-1,1]). Els mètodes que empren una funció de la distància, com els mètodes de veí més proper i màquines de vectors suport amb els nuclis de Gauss, són especialment sensibles a això. Un dels avantatges dels arbres de decisió és que es manegen fàcilment les dades heterogènies.

- Redundància en les dades. Si les característiques d'entrada contenen informació redundant (per exemple, les característiques altament correlacionades), alguns algoritmes d'aprenentatge (per exemple, la regressió lineal, regressió logística, i els mètodes basats en la distància) serà un mal acompliment a causa d'inestabilitats numèriques. Aquests problemes poden ser resolts mitjançant la imposició d'algun tipus de regularització.

- Presència d'interaccions i no linealitats. Si cadascuna de les característiques fa una contribució independent a la sortida, els algorismes basats en les funcions lineals i funcions de distància, en general fan un bon acompliment. No obstant això, si hi ha interaccions complexes entre les característiques, els algorismes com els arbres de decisió i xarxes neuronals funcionen millor, ja que estan dissenyats específicament per descobrir aquestes interaccions. També es poden aplicar mètodes lineals, però l'enginyer ha d'especificar manualment les interaccions a l'hora d'utilitzar-les.

Minimizació del risc empíric

[modifica]Donat un conjunt de punts de la forma (x, g(x)), l'aprenentatge supervisat ha de generar una funció g. Suposem que el conjunt de punts per què el comportament de g és conegut és una mostra de variables aleatòries independents distribuïdes d'acord amb una distribució de probabilitat desconeguda p. Es considera també una funció de pèrdua L:

d'on Y és la codominància de g, i L és una funció mapes en el número no negatiu. Es poden assignar diferents restriccions a L. La quantitat L(z,y) és la pèrdua soferta en la predicció de z, com el valor de g quan el seu valor vertader és y'.

El risc associat a una funció f és l'esperança matemàtica de la funció de pèrdua:

Si la distribució de probabilitat p és discreta es pot reescriure la fórmula anterior utilitzant una integral en comptes d'un sumatori.

Ara l'objectiu és trobar una funció f* on el risc R(f* ) sigui mínima.

Tot i això, donat el comportament dels g generalment només és conegut per un conjunt finit de punts (x1, y1), ..., (xnyn), només es pot aproximar el risc vertader, per exemple amb el risc empíric:

Selecció de la funció f* que minimitza el risc empíric es coneix com el principi de minimizació empírica de riscos. Teoría estadística d'aprenentatge investiga sota quines condicions la minimització del risc empíric és admissible i la bondat que són les aproximacions que s'esperen.

Resultats de les prediccions

[modifica]

A l'hora d'avaluar un classificador, s'utilitzaran unes dades de prova, que hauran de ser del mateix tipus i característiques que les utilitzades en la fase d'entrenament, que s'introduiran al programa dissenyat. A partir d'aquí, el detector generarà uns resultats a aquestes dades que haurem de comparar amb les anotacions manuals creades prèviament.

Per tal de comparar els resultats, es poden crear matrius de confusió, que relacionen els valors anotats per l'usuari (manual) amb aquells anotats pel classificador (automàtic). Així, aquells resultats que estiguin situats dins les caselles verdes correspondran a les deteccions correctes (la anotació manual i l'automàtica es corresponen) mentre que les que es trobin dins els quadres vermells seran erronis (l'anotació manual i l'automàtica no coincideixen).

En classificadors binaris, com per exemple detectors d'imatges de dia o nit, la matriu de confusió corresponent als resultats de la seva avaluació seria d'aquesta forma:

On:

- tp: True positives (Manual: positiu; Automàtic: positiu)

- tn: True negatives (Manual: negatiu; Automnàtic: negatiu)

- fp: False positives (Manual: negatiu; Automàtic: positiu)

- fn: False negatives (Manual: positiu; Automàtic: negatiu)

A partir d'aquests resultats es pot calcular la precisió (P) i el record(R).

Generalitzacions de l'aprenentatge supervisat

[modifica]Hi ha diverses maneres en què la norma del problema d'aprenentatge supervisat es pot generalitzar:

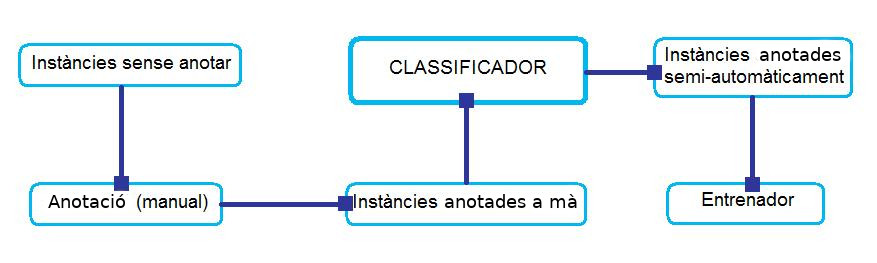

- Aprenentatge semi-supervisat: En aquest context, els valors de sortida desitjada es proporcionen només per a un subconjunt de les dades d'entrenament. La resta de dades està etiquetat.

- Aprenentatge actiu: En lloc d'assumir que tots els exemples d'entrenament es donen a la sortida, activa algoritmes d'aprenentatge interactiu per recollir nous exemples, en general en fer consultes a un usuari humà. Sovint, les consultes es basen en dades d'etiqueta, que és un escenari que combina l'aprenentatge semi-supervisat amb l'aprenentatge actiu. Són abundants les situacions on les dades no disposen d'etiquetes però les dades d'etiquetatge són cares. Aquest tipus d'aprenentatge pot ser molt útil en problemes d'investigació biològica, biologia computacional i bioinformàtica.

- Predicció estructurada: Quan el valor de sortida desitjat és un objecte complex, com un arbre d'anàlisi o un gràfic de l'etiqueta llavors els mètodes estàndard han de ser ampliats.

- Aprendre a classificar: Quan l'entrada és un conjunt d'objectes i la sortida desitjada és una classificació dels objectes, de nou els mètodes estàndard han de ser ampliats.

Aplicacions

[modifica]- Bioinformàtica

- Quimioinformàtica

- Màrqueting de bases de dades

- Reconeixement d'escriptura

- Recuperació d'informació

- Aprendre a classificar

- Reconeixement d'objectes

- Reconeixement òptic de caràcters

- Detecció de correu brossa (spam)

- Reconeixement de patrons

- Reconeixement de veu

Vegeu també

[modifica]- Intel·ligència artificial

- Aprenentatge automàtic

- Validació creuada

- Teorema de Bayes

- Xarxes neuronals

- Classificació

- Mineria de dades

Referències

[modifica]- ↑ «aprenentatge supervisat». Cercaterm. TERMCAT, Centre de Terminologia.

Bibliografia

[modifica]- S. Kotsiantis, supervisado Aprendizaje Automático: Una Revisión de la Clasificación de las técnicas de Informatica Diario 31 (2007) 249-268.

- Lise Getoor y Taskar Ben: Introducciónaestadística de relación de aprendizaje, MIT Press, 2007

- L. Breiman (1996). Heuristics of instability and stabilization in model selection. Annals of Statistics 24(6), 2350-2382.

- G. James (2003) Variance and Bias for General Loss Functions, Machine Learning 51, 115-135. (http://www-bcf.usc.edu/~gareth/research/bv.pdf Arxivat 2020-12-08 a Wayback Machine.)

- S. Geman, E. Bienenstock, and R. Doursat (1992). Neural networks and the bias/variance dilemma. Neural Computation 4, 1–58.

- Vapnik, V. N. The Nature of Statistical Learning Theory (2nd Ed.), Springer Verlag, 2000.